Dlaczego AI w bezpieczeństwie to dziś (przede wszystkim) problem, nie tylko rozwiązanie wielu problemów.

Sztuczna inteligencja w obszarze ogólnego IT (nie tylko cyberbezpieczeństwa) to dziś temat gorący, ale również pełen mitów, przeświadczeń I hype’u.

Dostawcy rozwiązań każą nam wierzyć, że narzędzia „AI-powered” wykryją, sprawdzą, poprawią i generalnie zrobią wszystko za administratorów, inżynierów oraz innych specjalistów.

Case ten urósł już do takiego rozmiaru, że wszystko co nie jest AI based, jest wręcz prehistoryczne, mierne oraz zupełnie niegodne uwagi.

Pamiętajmy – nie wszystko złoto co się świeci!

Przykład z życia wzięty:

- Jeden dostawca nazwał prostą korelację reguł AI

- Inny zaś model ML trenowany na flow logach

- Jeszcze inny integrację z ChatGPT do raportów

Efekt? Administrator otrzymuje narzędzie, którego:

- Nie rozumie

- Nie potrafi debugować

- Nie wie, dlaczego coś zostało wykryte a dlaczego nie

W tym artykule pokażemy, gdzie AI faktycznie działa i czego oczekiwać od takich rozwiązań.

Co dostawcy nazywają AI – a co nim faktycznie jest

Najczęściej możemy spotkać cztery rzeczy sprzedawane jako rozwiązania bazujące na sztucznej inteligencji:

- Reguły i heurystyki – prosty if/else, thresholdy, korelacje zdarzeń. To nie jest AI.

- Uczenie maszynowe (Machine Learning) – modele uczone na danych historycznych, np. anomaly detection. To jest prawdziwe AI.

- LLM (Large Language Models) – analiza logów w języku naturalnym, raportowanie. Nie wykrywają ataków.

- Automatyzacja (SOAR) – playbooki, reakcje na alerty. Nie jest to AI.

Prosta zasada: jeśli nie wiesz, co dokładnie robi AI w Twoim narzędziu, to jest to czerwona flaga oraz sygnał ostrzegawczy, który sugeruje, że:

- Narzędzie moze być wykorzystywane “na ślepo”,

- Nie wykorzytujemy narzędzia optymalnie,

- Może niekoniecznie ten AI to AI.

Gdzie AI realnie działa w cyberbezpieczeństwie

Główne zastosowania dla sysadmina:

- Anomaly detection – nietypowy ruch sieciowy, skanowanie, beaconing C2

- Log analysis – grupowanie logów, wykrywanie odchyleń od normy

- Alert triage – pomoc w sortowaniu alertów według ryzyka

- Behavioral profiling – baseline zachowań użytkowników i hostów

AI nie zastępuje człowieka, ale może odciąć 80–90% szumu i pomóc skupić się na realnych problemach.

Gdzie AI NIE działa

- Zero-day – brak powtarzalnego wzorca

- Małe środowiska – brak danych i stabilnego baseline’u

- Brak kontekstu – model nie wie, co to backup czy maintenance

- False sense of security – źle wdrożone AI generuje fałszywe poczucie bezpieczeństwa (!!)

Klucz: AI jest wzmacniaczem, nie magiczną tarczą.

Gdzie AI działa, a gdzie nie działa – przykłady

| Działa dobrze | Nie działa |

| Detekcja anomalii | 0-day |

| Analiza logów | Małe środowiska |

| Alert triage | Brak kontekstu |

| Profilowanie behawioralne | False sense of security |

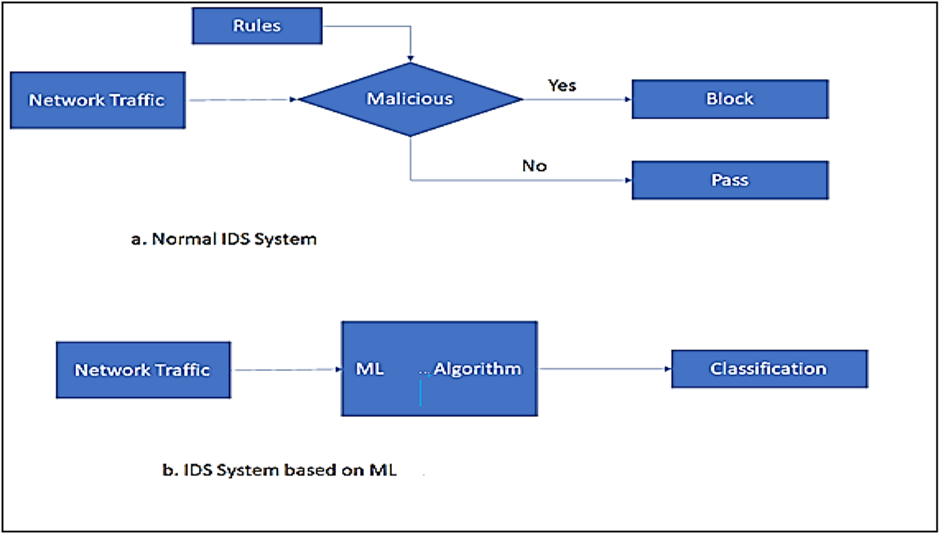

Aby lepiej zobrazować różnice w klasycznym podejściu a podejściu real AI based, zobaczmy jak wygląda to w kontekście IDS.

Mamy tutaj do czynienia z sytuacją gdzie IDS jest w stanie “wytrenować się” na dużej ilości ruchu sieciowego, który przezeń przechodzi. Na bazie tego będzie potrafił sklasyfikować ruch. Istotne będzie tu zrozumienie co ten ML I Algorithm będzie rzeczywiście robił, tak aby nie paraliżował nam działania sieci oraz nie był zbyt liberalny przy klasyfikacji danych pakietów. Dlatego niesamowicie istotna będzie jakość danych, na których będzie się trenował.

W kolejnym artykule dowiesz się min jak AI wspiera pipeline‘y oraz wspiera decyzje architektoniczne.

Zostaw komentarz

Musisz się zalogować lub zarejestrować aby dodać nowy komentarz.